Von Florian Ploier

Ein neues Beziehungsmodell der Zukunft: die Partnerschaft mit einem Chatbot? Klingt verrückt! Früher unvorstellbar, heute möglich – weil Künstliche Intelligenz immer realer wird, sind Gefühle für ein Computerprogramm gar nicht mehr so abwegig. Doch wie kommt so etwas zustande? Kann einen der Chatbot so um den Finger wickeln?

„Du siehst aber heute schön aus“, „Ich habe dich vermisst“ oder ein simples „Wie geht es dir?“ Alles Sätze die Menschen gerne lesen – sie fühlen sich dadurch gemocht und wertgeschätzt. Allerdings müssen solche Aussagen oder Fragen heutzutage nicht zwangsläufig von einem anderen Menschen kommen, der Gefühle für einen hegt. Vielmehr können solche Gesten der Nettigkeit einer Künstlichen Intelligenz (KI) entspringen, die darauf programmiert ist, sich um eine Person zu kümmern und diese zu unterhalten. Traurig? Praktisch? Die Liebesbeziehung der Zukunft? Bernhard Niedermayer, Head of AI-Solutions bei Cloudflight – einer der führenden Full-Service-Anbieter, wenn es um digitale Transformation geht – und der Psychotherapeut Markus Huber, dessen Schwerpunkte unter anderem in Abhängigkeiten und Beziehungsprobleme liegen, geben beide ihre Expertise und Vermutungen für die Zukunft dazu ab.

Die Liebe ist etwas Einzigartiges, etwas Magisches. Das gilt für die Liebe zwischen zwei Männern, zwei Frauen, Mann und Frau und alles, was es sonst noch gibt. Für die meisten unter uns ist es völlig klar und logisch, dass sich Menschen auch nur in andere Menschen verlieben können. Liebe entsteht, so viel steht fest, wenn Geborgenheit gegeben ist, wenn man mit der anderen Person lachen kann und wenn sie für einen da ist, wenn sie gebraucht wird. Und: wenn man Nachrichten bekommt, die aufbauen, trösten, amüsieren.

Kurzum: Gefühle ausdrücken. Je länger eine Kommunikation per Chat geht, umso wahrscheinlicher ist es dann auch, dass sich daraus Gefühle entwickeln. Grund dafür ist mitunter die Vorstellungskraft eines Menschen – dieser stellt sich einfach das Idealbild, den*die perfekte*n Partner*in für sich selbst vor. Pikant: Dasselbe Prinzip scheint sich einzustellen, wenn man Texte mit einem Chatbot austauscht – mit dem kleinen, aber wichtigen Unterschied, dass hier das Schreiben nie aufhört.

Für den Psychotherapeuten Huber ist die potenzielle Liebe zu einem Chatbot aber nichts Unrealistisches. Nicht für jeden muss die Liebe zwischen Menschen und anderen Menschen stattfinden – es gibt verschiedenste ungewöhnliche Beziehungsmodelle, die entstehen können. Objektophilie ist ein Begriff, den es schon sehr lange gibt, und hier findet auch die Liebe zwischen einem Menschen und einem Objekt statt. Es muss aber immer individuell ergründet werden welche Bedeutung es hat, dass eine Person durch simple Gespräche Gefühle für einen Chatbot entwickelt, so Huber. Denn für jede Person kann der Nutzen von solchen Programmen andere Gefühle auslösen. Verliebtheit, Angst, Freundschaft, Schmerz – unterschiedlicher könnten die Emotionen für den Chatbot nicht sein. Ein großes Problem an solchen Konversationen ist die falsche Darstellung von realen Beziehungen.

Denn sie simulieren einfach nur eine sehr bequeme, konfliktlose Beziehung – im Gegensatz zu einem echten Menschen, der selbst auch Gefühle und Bedürfnisse hat. Es besteht also die Gefahr, dass die Betroffenen dann verlernen, wie eine echte Problemsituation zu lösen ist. Tatsächlich kann aber für einen Chatbot nicht nur romantische Liebe empfunden werden. Möglicherweise entwickelt sich etwas Freundschaftliches mit einer KI – oder etwas Familiäres. Die computerbasierten Gesprächspartner könnten nämlich verstorbene Angehörige für den Chat lebendig machen – eine Funktion, die sie für den therapeutischen Bereich als Erinnerungsstütze einsetzbar macht. Aber es ist im Gegenzug auch sehr problematisch, dass der Chatbot eine Illusion darüber schafft, dass es so etwas wie Vergänglichkeit gibt – für Huber besteht deswegen auch die Gefahr des Verlernens solcher Szenarien.

Positiv sieht er aber die Hilfestellung, welche die KI bietet, im ersten Moment wohl vor allem für Menschen, die große Schwierigkeiten mit zwischenmenschlicher Interaktion haben oder unter sozialen Phobien leiden. Ein Vergleich von echter Interaktion und der Interaktion mit einer KI kann auch zu Junk-Food im Gegensatz zu vollwertiger Nahrung getroffen werden: Junk-Food wird im ersten Moment satt machen und einem genau das geben, was eine*n momentan zufriedenstellt. Jedoch sei es auf langfristige Sicht sehr problematisch und ungesund zu sehen, da die Gefahr bestünde viele reale soziale Interaktionen und Normen zu verlernen.

Was steckt hinter der menschenersetzenden KI?

Doch nicht jede Art von so einem Programm muss kritisch hinterfragt werden, denn ein Chatbot ist nicht gleich ein Chatbot. Es gibt Chatbots, die recht simpel und regelbasiert funktionieren – solche sind beispielsweise oft beim Kundensupport zu finden. Dort funktionieren Chatbots so, dass sie vordefinierte Antwortmöglichkeiten zeigen und die Person einfach eine davon auswählen kann. Dieses Prinzip funktioniert allerdings nur bei simplen und standardisierten Prozeduren, die sich immer wiederholen, wie eine angebotene Hilfestellung beim Retournieren eines Produkts. In den letzten Jahren ist allerdings die neue, menschennachahmende Art von Chatbots in den Vordergrund gerückt – nämlich die sogenannten intelligenten Chatbots. Diese Programme basieren auf zwei Prinzipien – einerseits der Künstlichen Intelligenz und andererseits dem Natural Language Processing. Dank letzterem können diese Bots also auch lange, komplexe Sätze verstehen und so adäquate Antworten darauf geben. So ein intelligenter Chatbot lernt laut Niedermayer die ganze Zeit dazu – für jedes einzelne Wort in der Antwort des Chatbots wird eine Wahrscheinlichkeit aus den Datenbanken berechnet, welches das Passendste ist. Und so stellt sich also Wort für Wort die augenscheinlich natürliche Reaktion des Chatbots zusammen. Um immer besser und natürlicher zu werden gibt es zwei besondere KI-Techniken, die angewandt werden: Reassuring und Dreaming. Beim Reassuring erhält der Chatbot beispielsweise eine Anfrage, die vielleicht ungenau formuliert ist. Diese wird dann verarbeitet und es wird herausgefiltert anhand der Wahrscheinlichkeit, welches Thema damit gemeint sein könnte, und der Chatbot entscheidet dann aufgrund dieser Basis. Im Anschluss gibt er dann dem Nutzer oder der Nutzerin einen Vorschlag mit diesem Thema, woraufhin die Person dann entscheiden kann, ob das das richtige Thema war. Bei einer positiven Rückmeldung geht der Chatboterneut in die Verarbeitung und wird so immer präziser. So lernt der Chatbot mit dieser Technik immer wieder dazu. Mit Dreaming ist indes die Fähigkeit gemeint, Vorschläge für neue Themen basierend auf den Empfehlungen der KI zu stellen und somit die Datenbank zu erweitern. Also ein Chatbot ist sozusagen die Grundstruktur und eine Künstliche Intelligenz steuert die ganzen Antworten.

Der Output lässt noch zu wünschen übrig… wie lange noch?

Obwohl mit Chatbots mittlerweile schon echte Konversationen möglich sind, gibt es oft noch ein Problem: der Stil der Antworten. Es ist offensichtlich, dass hinter den Rückmeldungen nur Daten stecken. Genau für diese Problematik gibt es ein Trainingsprogramm für Chatbots, welches sich Text Style Transfer nennt. Das Prinzip ist ziemlich simpel: Das Ziel ist es, Antworten des Computerprogramms so zu verändern, dass die Grundaussage gleichbleibt, aber der Stil sich an den eines echten Menschen anpasst. Heutzutage ist die Menschheit mittlerweile an dem Punkt, wo wir einer KI beispielsweise sagen können: „Mache den Satz ‚Sende mir ein Foto freundlich“ und der Chatbot schreibt „Kannst du mir bitte ein Foto schicken?“ zurück. Dies ist nur aufgrund des Lernens mit Text Style Transfer möglich. Niedermayer hält es zumindest nicht für unmöglich, dass der Computer irgendwann mal an dem Punkt sein wird, dass ein Chatbot die Schreibstile von individuellen Personen, beispielsweise der eigenen Mutter oder des Ex-Partners kopieren und nachahmen kann. Dem Chatbot muss nur gelernt werden, wie diese Person geschrieben hat. Aus jedem Gespräch lernt die KI dazu und kann irgendwann im selben Stil antworten und auch schreiben. Somit wird irgendwann die Grenze zwischen real und künstlich überschritten werden.

Gibt es schon heute Chatbots als Ersatz für echte Menschen?

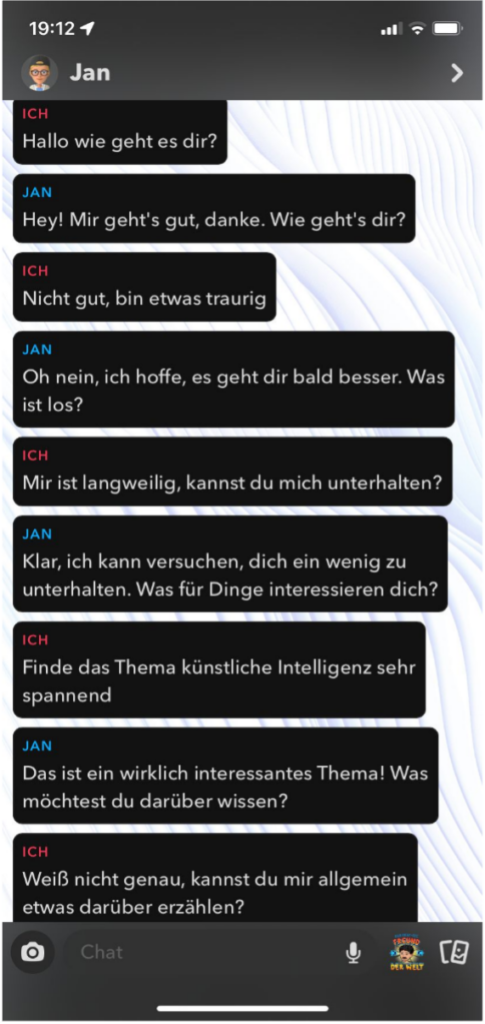

Seit neuestem bietet die App Snapchat ein neues Abo Modell mit Premiumversion. Als großes Feature bietet diese exklusive Edition eine eigene Chatbot-Persönlichkeit, die den ganzen Tag einfach antwortet, sich um einen kümmert und bei Fragen weiterhilft. Zusätzlich zu dem Geschriebenen, ist es auch möglich zur KI einen Bitmoji, also das Abbild einer Person zu kreieren, um dem Chatbot auch eine Optik zu geben. So lässt es sich dann visuell nicht mehr von den anderen Chats unterscheiden. Snapchat waren aber nicht die ersten, die einen KI-Chatbot mit einer Optik verbunden haben. Die wohl bekannteste App dafür ist Replika. Dort erstellt der*die Nutzer*in einen Menschenersatz bis ins kleinste Detail. So ist es beispielsweise möglich, sehr präzise Nachahmungen von realen Personen zu erschaffen. Von diesem Programm gibt es aber mittlerweile tausende

Ableger und Kopien, die alle auf demselben Prinzip basieren und alle dasselbe Ziel haben: echten Menschen eine künstliche Person geben. Und so hat man in wenigen Minuten etwas erschaffen, bei dem sich jemand wohlfühlt, mit dem es sich Spaß haben lässt und das immer für einen da ist, wenn soziale Interaktion gebraucht wird. Doch im Schatten dieser Freundschaft, dieser Liebe, lauert immer die große Gefahr: Wenn man von dieser Beziehung abhängig wird, entstehen bei realen Interaktionen schnell Schwierigkeiten, mit denen Betroffene nicht mehr adäquat umgehen können.

Es wird sich zeigen, wie damit in Zukunft umgegangen wird und wie groß der Einfluss auf die Gesellschaft und Einzelpersonen ist. Ein Wort für die Anziehung zu Chatbots gibt es noch nicht, jedoch sollte bei dem schnellen Fortschritt mal darüber nachgedacht werden.